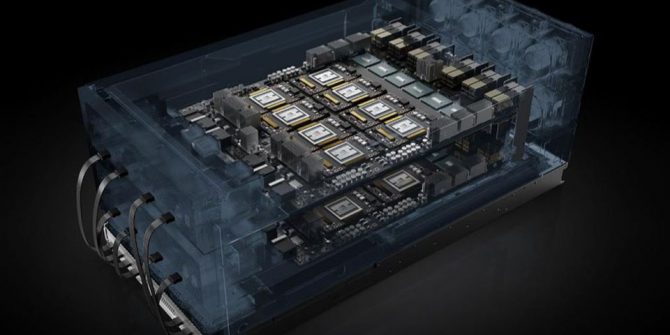

NVIDIA HGX-2 được định vị như một nền tảng máy chủ đám mây được hỗ trợ bởi các GPU NVIDIA Tesla V100 và NVSwitch, mang lại sức mạnh tính toán to lớn với băng thông cao nhất. Dựa trên 16 card GPU Tesla V600, đi kèm với bộ nhớ 0.5 terabyte. Những GPU này được kết nối trực tiếp bởi 12 NVSwitch của NVIDIA để cung cấp băng thông chưa từng có, 2,4TB / giây.

NVIDIA tuyên bố rằng một HGX-2 có thể thay thế 300 node server dùng CPU, dual socket Intel Xeon Gold 6140. Chỉ số benchmark này dựa trên việc đào tạo mô hình ResNet50 với 15.500 cho 90 epochs. Khi nói đến khối lượng công việc của HPC (máy chủ hiệu suất cao), một HGX-2 có thể thay thế 60 node máy chủ dùng CPU (CPU-based-server) để xử lý tác vụ.

NVIDIA DGX-2, được công bố tại GTC ở Santa Clara hồi đầu năm nay, là một trong những hệ thống đầu tiên được chế tạo dựa trên HGX-2.

HGX-2 là thế hệ kế tiếp của HGX-1, ban đầu được thiết kế bởi Microsoft. Kiến trúc và thông số kỹ thuật sau này đã được “mở”- open source, như một phần của Open Compute Project. Dòng sản phẩm P3 của Amazon EC2 dựa trên cùng một nền tảng HGX-1. NVIDIA chưa công bố kế hoạch open source thiết kế của HGX-2 hay không

.

NVIDIA đang hợp tác với một số nhà sản xuất hàng đầu để thúc đẩy mô hình điện toán đám mây AI (AI cloud computing): Cung cấp bo mạch chủ HGX-2 GPU, hướng dẫn thiết kế và truy cập sớm vào các công nghệ GPU để các đối tác tích hợp vào máy chủ và phân phối ở quy mô cho hệ sinh thái data center của họ. Foxconn, Inventec, Lenovo và QCT là một số nhà sản xuất thiết bị gốc đang hợp tác với NVIDIA để xây dựng các máy chủ HGX-2 cloud server. Các OEM này sẽ cho phép các nhà cung cấp dịch vụ đám mây Public cung cấp các dịch vụ cơ sở hạ tầng dựa trên HGX-2.

NVIDIA đang dẫn đầu làn sóng AI và HPC. NVidia cung cấp sản phẩm ở các phân khúc, để đảm bảo rằng hãng vẫn là người dẫn đầu thị trường cho GPU. Từ các entry level đến các máy chủ đám mây cao cấp.

GPU được dự báo là sẽ thúc đẩy việc lựa chọn quyết định cơ sở hạ tầng thế hệ tiếp theo như thế nào. Các nhà cung cấp dịch vụ cloud lớn bao gồm Amazon, Google, IBM và Microsoft đang cung cấp các máy ảo mạnh mẽ được hỗ trợ bởi dòng GPU NVIDIA Pascal và Tesla. Các máy ảo này rất cần thiết cho việc đào tạo các mô hình học – machine learning, cũng như chạy các công việc tính toán hiệu năng cao như mô hình hóa dữ liệu di truyền (genomic).

Google đang đầu tư mạnh vào các sản phẩm TPU độc quyền trên nền tảng đám mây của mình. Microsoft đang hợp tác với Intel để cung cấp cơ sở hạ tầng dựa trên FPGA, platform để chạy các công việc AI và HPC trên Azure. Khi các nhà cung cấp dịch vụ điện toán đám mây đang thực hiện các động thái hướng tới việc hợp tác và tự sản xuất hạ tầng của riêng mình, NVIDIA đang tích cực tăng cường đầu tư mạnh mẽ vào trò chơi mà mình chơi tốt nhất.

NVIDIA HGX-2 là bước đi hướng tới giữ vững vị thế dẫn đầu của công ty trong phân khúc GPU và HPC.